当我们用手机拍摄高清照片时,总会下意识地和人眼的视觉体验对比。那么,人类的眼睛究竟相当于多少万像素的相机?这个问题看似简单,却藏着视觉科学与成像技术的深层关联。

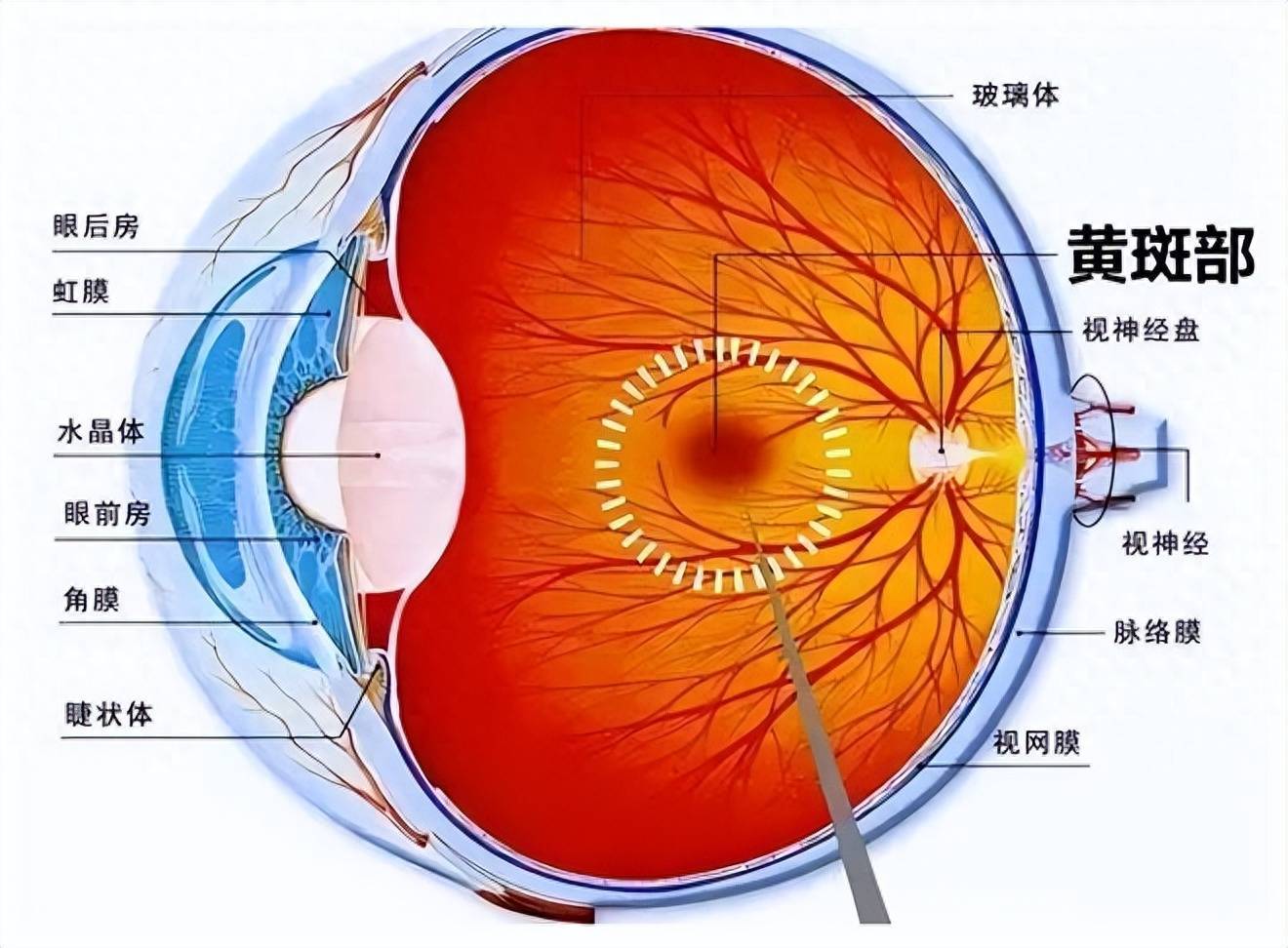

要解答这个问题,首先得从人眼的 “硬件配置” 说起。人眼的成像核心是视网膜上的感光细胞,其中负责高分辨率视觉和色彩感知的视锥细胞是关键。在视网膜的黄斑区,尤其是中央凹部位,视锥细胞密度最高 —— 每平方毫米可达 15 万个以上。整个视网膜上的视锥细胞约有 600 万至 700 万个,它们如同相机传感器上的像素点,负责捕捉光线中的细节。

但直接用视锥细胞数量等同于像素并不准确。相机的像素是均匀分布的网格状结构,而人眼的视锥细胞分布呈 “中心密集、边缘稀疏” 的梯度。中央凹区域仅 1.5 平方毫米,却集中了约 30% 的视锥细胞,能分辨 0.1 毫米的细节;而视网膜边缘的视锥细胞密度骤降,更多依赖感知运动和明暗的视杆细胞。这种分布模式让人类的视觉形成了 “中央清晰、周边模糊” 的动态范围,与相机全画幅均匀像素的成像逻辑截然不同。

科学家们通过视角换算得出了更合理的估算:人眼的水平可视角度约 120 度,垂直约 60 度,每度视角内可分辨 60 个视锥细胞。按此计算,人眼的视觉分辨率约为 5.76 亿像素 —— 这个数字相当于 57600 万像素。这意味着,人眼一次性 “拍摄” 的画面,需要近 6 亿个像素点才能完整还原。

不过,这个数字只是粗略的类比。相机的像素是静态的物理感光单元,而人眼的视觉系统是 “生物 + 神经” 的动态协作系统:角膜和晶状体相当于镜头,负责聚焦光线;瞳孔如同光圈,调节进光量;视网膜的感光细胞将光信号转化为神经电信号,再通过视神经传输到大脑视觉皮层处理。大脑会自动填补视觉盲区、修正色差、增强动态对比,甚至结合记忆和经验 “脑补” 细节 —— 这种实时处理能力,是任何相机传感器都无法复制的。

更重要的是,人眼的 “动态范围” 远超相机。相机的动态范围通常在 10-14 档,而人眼能在强光下分辨白云的纹理,也能在弱光中识别星星的微光,动态范围高达 20 档以上。此外,人眼对色彩的感知是连续的光谱解析,而相机依赖红、绿、蓝三色滤镜的组合,在色彩过渡和自然度上始终存在差距。

说到底,用 “像素” 衡量人眼,就像用 “分贝” 描述交响乐 —— 只能捕捉一个维度的参数,却无法涵盖其本质的复杂与精妙。人眼不是一台精密的相机,而是一套历经亿万年进化的 “超级视觉系统”,它的价值不在于静态的分辨率数字,而在于动态适应环境、解读世界的生命力。